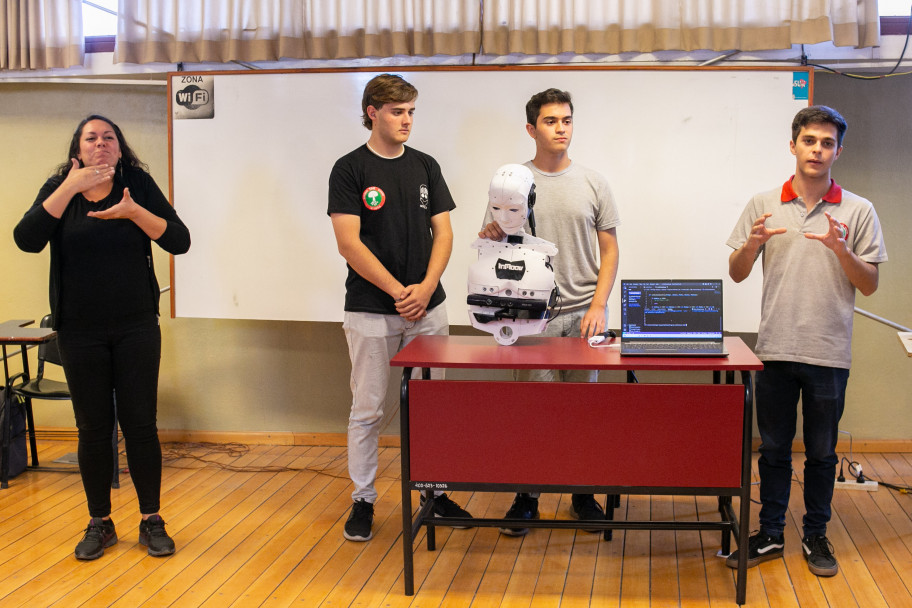

Tres estudiantes de la Escuela Tomás Alva Edison de Mendoza visitaron la Facultad de Educación, específicamente el espacio curricular "Taller de Interpretación 1" de la Tecnicatura en Interpretación de Lengua de Señas a cargo de las profesoras Beatriz Pellegrini, Noelia Soto y Gabriela Guzmán, para exhibir el proyecto en el que trabajan. Se trata de un robot que decodifica las señas que realizan las personas sordas, y las transcribe de forma escrita y oral a fin de favorecer la comunicación con personas oyentes. En él trabajan Santiago Vázquez, Juan Cruz Ledesma y Tomás Donoso, quienes asistieron acompañados de Graciela Bertancud, presidenta de la Fundación Tomás Alva Edison y fundadora de la primera escuela de Robótica de Argentina Probot School.

"Estamos desarrollando un programa para que a través del robot se detecte e interprete la Lengua de Señas, y la persona sorda pueda comunicarse con quien no sabe la lengua. También podría servir para enseñarla", explicó Santiago. Además, Bertancud agregó que las señas y su interpretación están cargadas en una base de Inteligencia Artificial, "a la que hay que ir educando y generando todos los códigos de la Lengua de Señas Argentina".

Del encuentro también participó la decana, Ana Sisti, quien celebró la iniciativa y el interés de los jóvenes en estos temas. Además, los convocó a trabajar junto a la Facultad a fin de generar instancias de aprendizaje mutuo y de crecimiento. "La robótica y la programación son ciencias que en el caso de la Lengua de Señas son positivas, porque justamente apuntan a lo visual, propio de esta lengua, es lo que nos lleva a pensar otro tipo de comunicación. Por supuesto que hay que analizarlo en conjunto con la Comunidad Sorda y tener presente que siempre puede favorecer y ser perfectible", señaló.

Los invitados agradecieron el encuentro que compartieron junto a estudiantes y docentes. "Nos pareció fantástico poder venir, interactuar con ustedes y la comunidad sorda para poder nosotros mejorar la propuesta que queremos", afirmaron.

Cómo funciona el robot

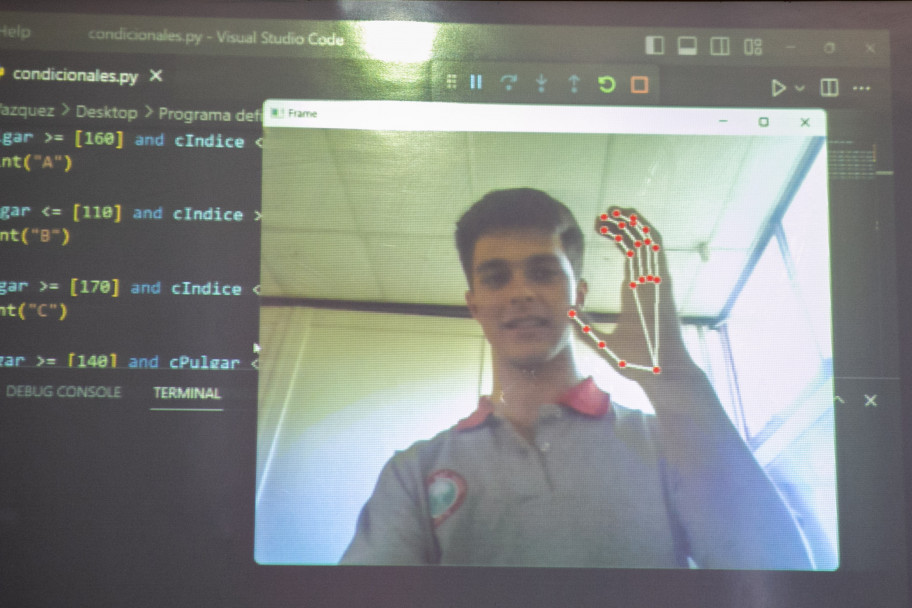

El robot combina programación, inteligencia artificial e impresión 3D. A partir de su diseño, puede observar a una persona hablando en Lengua de Señas y traducir el mensaje de manera escrita y oral. Actualmente está en proceso y sólo detecta algunas letras del abecedario, particularmente las que no implican movimientos en su traducción.

"El programa se entrena con un interpretador de imágenes donde a través de una galería de muchas fotos que sacamos nosotros, se les dan los gestos de las letras y luego cuando se replican en la cámara de la computadora, en la pantalla las imprime y las muestra decodificadas. La idea es que cuando una persona sorda haga señas frente al robot, la cámara que esta adelante los tome y traduzca de forma oral o escrita lo que está queriendo decir", explicaron acerca del funcionamiento. El equipo trabaja en la impresión 3D desde febrero y en el software comenzaron en marzo.

Graciela Bertancud explicó que una de las funciones en la que piensan que puede ser útil el robot es en el ámbito de salud. "Aspiramos a que la persona sorda llegue a un centro de salud u hospital y pueda ser asistida; que pueda expresar lo que le pasa o siente sin tener que esperar a tener alguien que lo interprete. Se puede hacer extensivo a la educación también", señaló.